How to Install and Configure LXC Container on Ubuntu 16.04

Запустить орла в lxd, полноценно перенести напрямую не удалось глючит - интерфейс.

Выбран путь хост орел lxc орел, контейнер lxc переносим на ubuntu 18.04 в контейнере lxd

Перенос контейнера lxc в lxd на другую машину

копируем контейнер с орлом на орле

$ sudo -i

# cd /var/lib/lxc/

# tar --numeric-owner -jcvf /home/user/astra.tar.bz2 astra/

Создаем на хосте контейнер astralxc

$ lxc launch ubuntu:18.04 astralxc

$ lxc config set astralxc security.privileged true

$ lxc config set astralxc security.nesting true

$ lxc restart astralxc

$ lxc exec astralxc bash

# ip a

192.168.1.187

# apt update

# apt-get install bridge-utils

# nano /etc/netplan/50-cloud-init.yaml

# This file describes the network interfaces available on your system

# For more information, see netplan(5).

network:

version: 2

# renderer: networkd

ethernets:

eth0:

dhcp4: yes

bridges:

br0:

interfaces: [eth0]

addresses: [192.168.1.187/24]

gateway4: 192.168.1.1

mtu: 1500

nameservers:

addresses: [8.8.8.8]

parameters:

stp: true

forward-delay: 4

dhcp4: no

dhcp6: no

Сохранить.

# reboot

$ lxc exec astralxc bash

# apt update

# apt install lxc mc

# nano /etc/default/lxc-net

USE_LXC_BRIDGE="false"

# nano /etc/lxc/default.conf

lxc.net.0.type = veth

lxc.net.0.link = br0

lxc.net.0.flags = up

lxc.net.0.hwaddr = 00:16:3e:xx:xx:xx

# service lxc-net restart

# apt install lxc-templates

## lxc-create -n ubuntu -t ubuntu

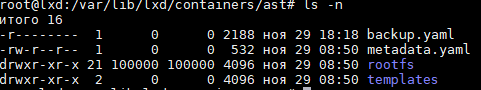

# cd /var/lib/lxc/

# tar jxfv /root/astra.tar.bz2

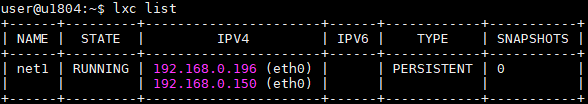

# lxc-ls -f

# lxc-start -n astra

# lxc-stop -n astra

# lxc-destroy -n astra

# lxc-console -n astra

$ lxc copy astralxc astralxc-cop

$ lxc start astralxc

$ lxc exec astralxc bash

# lxc-start -n astra

# lxc-console -n astra

admin

astralinux

$ sudo apt update

$ sudo dpkg-reconfigure locales

## Выбираем ru_RU.UTF-8

$ sudo dpkg-reconfigure tzdata

$ sudo apt install keyboard-configuration

## dpkg-reconfigure keyboard-configuration

$ sudo apt install mc ssh fly-data fly-wm

$ sudo reboot

$ sudo lxc-console -n astra

$ sudo apt install xrdp

$ ip a

192.168.1.189

$ sudo reboot

Запустить орла в lxd, полноценно перенести напрямую не удалось глючит - интерфейс.

Выбран путь хост орел lxc орел, контейнер lxc переносим на ubuntu 18.04 в контейнере lxd

Перенос контейнера lxc в lxd на другую машину

копируем контейнер с орлом на орле

$ sudo -i

# cd /var/lib/lxc/

# tar --numeric-owner -jcvf /home/user/astra.tar.bz2 astra/

Создаем на хосте контейнер astralxc

$ lxc launch ubuntu:18.04 astralxc

$ lxc config set astralxc security.privileged true

$ lxc config set astralxc security.nesting true

$ lxc restart astralxc

$ lxc exec astralxc bash

# ip a

192.168.1.187

# apt update

# apt-get install bridge-utils

# nano /etc/netplan/50-cloud-init.yaml

# This file describes the network interfaces available on your system

# For more information, see netplan(5).

network:

version: 2

# renderer: networkd

ethernets:

eth0:

dhcp4: yes

bridges:

br0:

interfaces: [eth0]

addresses: [192.168.1.187/24]

gateway4: 192.168.1.1

mtu: 1500

nameservers:

addresses: [8.8.8.8]

parameters:

stp: true

forward-delay: 4

dhcp4: no

dhcp6: no

Сохранить.

# reboot

$ lxc exec astralxc bash

# apt update

# apt install lxc mc

# nano /etc/default/lxc-net

USE_LXC_BRIDGE="false"

# nano /etc/lxc/default.conf

lxc.net.0.type = veth

lxc.net.0.link = br0

lxc.net.0.flags = up

lxc.net.0.hwaddr = 00:16:3e:xx:xx:xx

# service lxc-net restart

# apt install lxc-templates

## lxc-create -n ubuntu -t ubuntu

# cd /var/lib/lxc/

# tar jxfv /root/astra.tar.bz2

# lxc-ls -f

# lxc-start -n astra

# lxc-stop -n astra

# lxc-destroy -n astra

# lxc-console -n astra

$ lxc copy astralxc astralxc-cop

$ lxc start astralxc

$ lxc exec astralxc bash

# lxc-start -n astra

# lxc-console -n astra

admin

astralinux

$ sudo apt update

$ sudo dpkg-reconfigure locales

## Выбираем ru_RU.UTF-8

$ sudo dpkg-reconfigure tzdata

$ sudo apt install keyboard-configuration

## dpkg-reconfigure keyboard-configuration

$ sudo apt install mc ssh fly-data fly-wm

$ sudo reboot

$ sudo lxc-console -n astra

$ sudo apt install xrdp

$ ip a

192.168.1.189

$ sudo reboot